はじめに

研究開発Grで機械学習関連の業務を担当している瀬戸です。前回は、GluonCVのモデルをSageMaker Neo + Jetson tx2 + DLRで動作させてみる - aptpod Tech Blogを紹介させて頂きました。今回は、intdash SDK for PythonとGluonCVを組み合わせた深度推論のモックを紹介したいと思います。

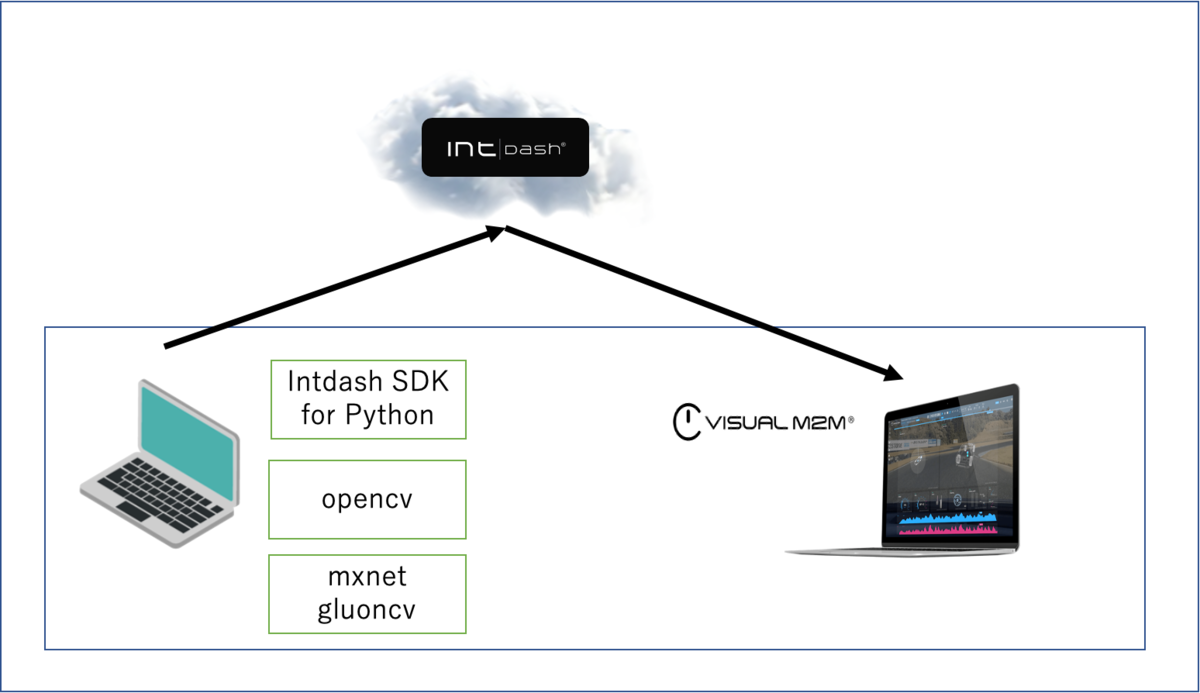

構成イメージ

今回のシステムの構成は以下の通りになります。手元のPCから、intdash SDK for Python + OpenCV + MXNet + GluonCVを使って、DeepLearningで推論した深度画像をintdashへ送信し、同じ手元のPCでVisual M2Mで見る構成となっています。

開発ツール

intdash SDK for Python

このSDKは、弊社製品であるintdashをPythonでアプリケーション開発を可能にする開発ツールです。ここに概要があります。また、ドキュメントは、ここにあります。

Visual M2M Data Visualizer

弊社製品のintdashにアップロードされているデータを可視化するために利用するブラウザアプリです。こちらに詳細があります。

GluonCV Toolkit

GluonCV Toolkit (以下、GluonCV)は、MXNetの持つパッケージの一つである Gluon をComputer Visionに特化する形で発展させたパッケージです。既知の有名な論文をベースにした学習済みモデルを提供するModel Zooや、新しいデータ拡張関数などが提供されています。

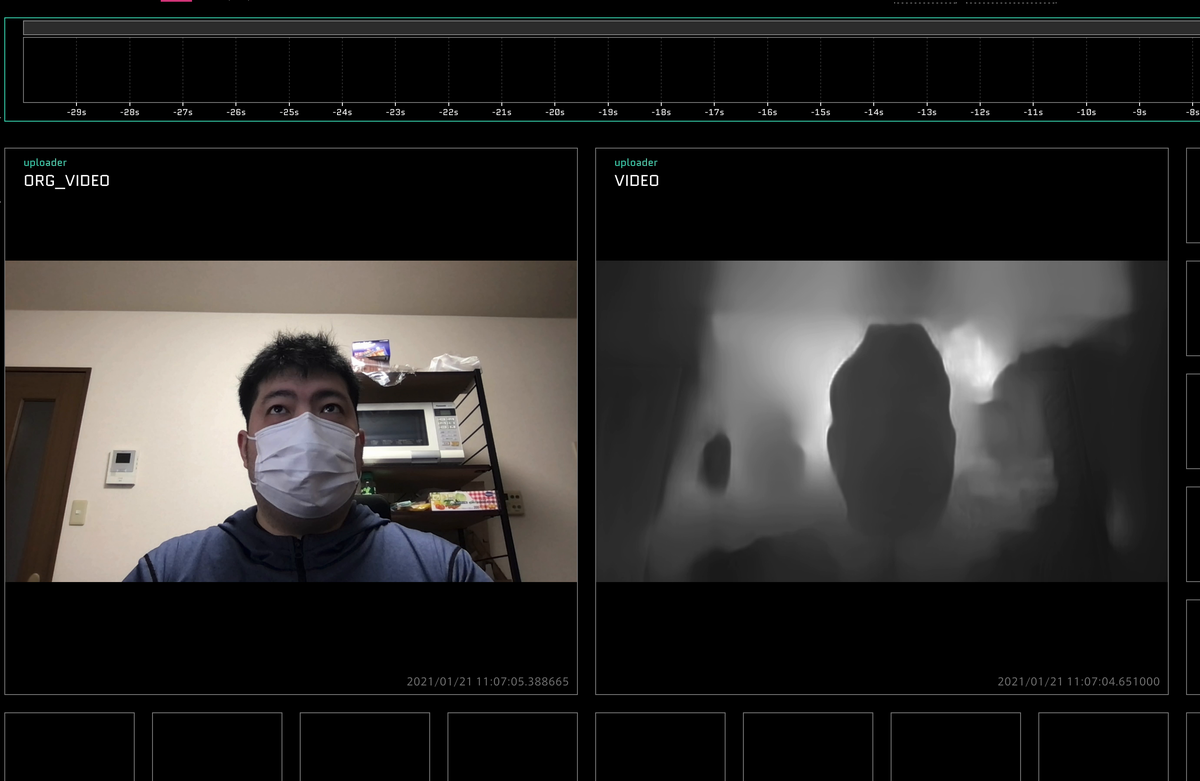

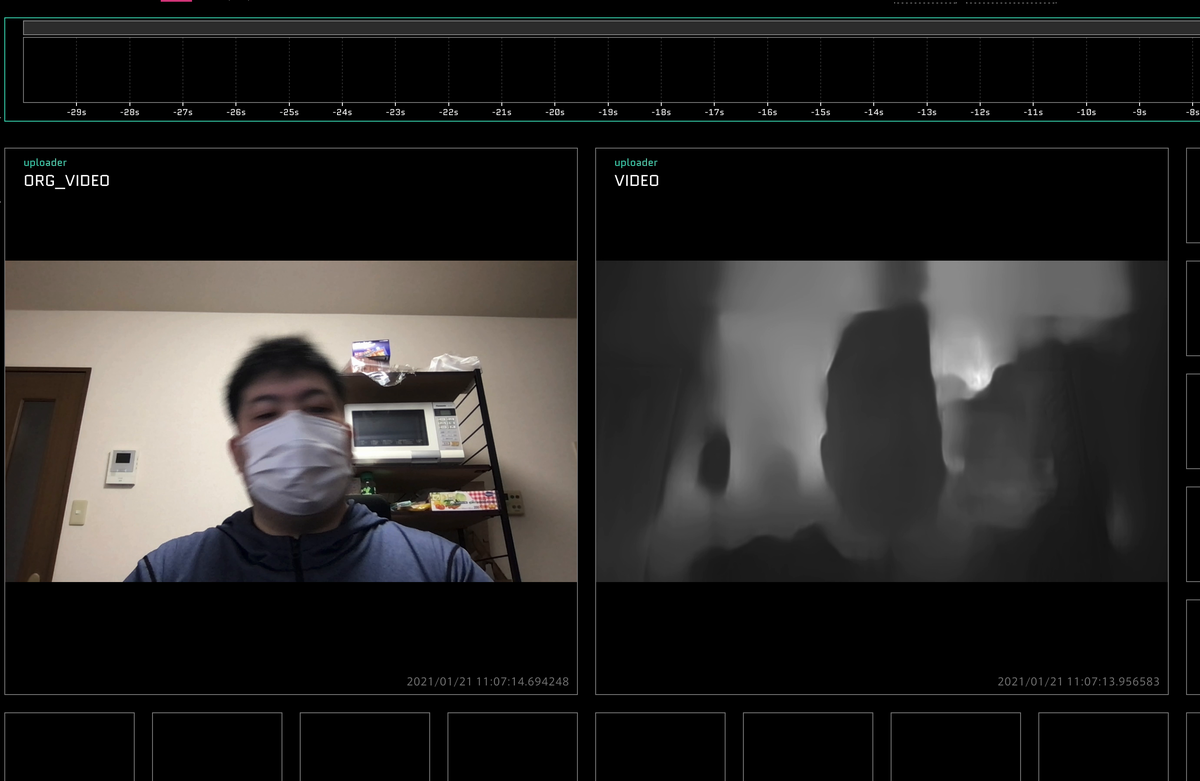

推論デモ

Data Visualizerで撮影した様子が以下の画像のようになります。なんとなく人のようなものが写っているのが見えるのと、後ろに物体があることがわかりそうな様子が見て取れました。

※今回のデモでは可視化のため、グレースケールで見やすくするための、深度のスケールを変更しています。

おわりに

今回は、深度推定の実力値などは調査せず弊社のフレームワークとDeepLearningのフレームワークを組み合わせた可視化のみとしました。今後は、引き続き、深度推定の実力値の調査やエッジデバイス上でのDeepLearningの推論などのサンプルを作っていこうと思っています。